Blog de cursos y estudiantes de Químicas del Departamento de Ciencias Quimico-Biológicas en la Universidad de las Américas Puebla.

Saturday, May 23, 2009

Wednesday, May 13, 2009

Fin de semestre. No mas entradas de cursos.

A partir del 12 de Mayo, ya no estoy contabilizando entradas para curso. Se agradecen de cualquier manera entradas posteriores a esta fecha, con el propósito de compartir y discutir información.

Saludos.

Aromaticidad en anillos metálicos

En base a las conclusiones a las que llegó Kekulé varios científicos se interesaron en el tema y fue Erich Hückel, quien a mediados del siglo XX, propuso una regla para determinar si una molécula es aromática (4n+2) o antiaromática (4n). Por la aportación de estos 3 científicos, y muchos otros, en la química orgánica se llegó a ciertas reglas para determinar la presencia de aromaticidad en las moléculas: se debe de tratar de una molécula plana, cíclica y que tenga 4n+2 electrones π deslocalizados.

Sin embargo, el término aromaticidad no es estático, ni se restringe a la química orgánica. La definición de aromaticidad ha ido evolucionando conforme la química avanza y se logran nuevos descubrimientos. Actualmente no tiene un significado preciso, ni denota directamente cantidades medibles, por lo que ahora se basa principalmente en observaciones experimentales y en métodos teóricos computacionales. Lo que lleva a los científicos a suponer que una molécula presenta aromaticidad es que es mucho más estable y simétrica de lo que debería de ser según su fórmula molecular.

El desarrollo del concepto de aromaticidad en función de la deslocalización electrónica permite explicar cómo este fenómeno puede ocurrir para otros sistemas. Aplicando el concepto de isolobalidad, se empezaron a preparar compuestos análogos al benceno, pero con un carbono sustituido por un metal. Se observó que dichas moléculas organometálicas también presentaban deslocalización electrónica, planarización y equivalencia entre los enlaces del anillo, excepto de los enlaces M-C como es de esperarse, además de la estabilización asociada a la aromaticidad.

En términos de reactividad, los metalobencenos sufren reacciones análogas a las del benceno y otras que no lo son. Se han reportado reacciones de cicloadición (Diels-Alder) y de coordinación η6 a centros metálicos, dando más evidencia del carácter aromático. Por otro lado, también se observan reacciones atípicas con respecto al benceno. Los metalobencenos reaccionan a bajas presiones y temperaturas con hidrógeno para dar un producto parcialmente hidrogenado, sin necesidad de un catalizador. Además se pueden presentar reacciones de adición oxidativa con oxígeno molecular triplete con mucha facilidad. En estas dos últimas reacciones se pierde la aromaticidad del anillo, y esto habla de un grado menor de estabilización asociado a la aromaticidad en comparación con el benceno.

Los metalobencenos, sin embargo, presentan únicamente aromaticidad π, ya que si el metal es de transición ocupa uno de sus orbitales d de simetría adecuada para formar parte de la deslocalización π, mientras que los metales del bloque p ocupan este tipo de orbitales para formar el sistema. Investigaciones más recientes han logrado producir e identificar ciclos formados completamente por metales, a los que se les llama comúnmente clusters metálicos. Se ha encontrado que muchos de estos clusters son más estables de lo que se esperaría tomando en cuenta que los enlaces metal-metal son lábiles en general.

Con la teoría del orbital molecular, la aromaticidad se ha comprendido como un fenómeno de deslocalización electrónica a lo largo de una estructura cíclica. Uno de los criterios que más se ocupa para identificar si hay aromaticidad o no es la planarización de la molécula. La planarización permite que los orbitales p estén paralelos y de esa forma se pueden traslapar de manera efectiva para formar un orbital molecular deslocalizado. Sin embargo, la planarización no es un criterio concluyente, ya que se han encontrado moléculas orgánicas aromáticas no planas, sobre todo ciclos más grandes como el [18]-anuleno. La regla de Hückel que se considera como el criterio más importante para determinar la aromaticidad de un ciclo tampoco es infalible, en muchos sistemas se aplica, pero en otros no. Lo que sucede es que muchos de estos conceptos resultan ser arcaicos e inaplicables para clusters metálicos, donde los átomos tienen otros tipos de orbitales atómicos que pueden participar en enlaces deslocalizados.

El descubrimiento de aromaticidad en otro tipo de compuestos donde no se tenían orbitales p disponibles hizo que se introdujera el concepto de aromaticidad σ. Este tipo de aromaticidad debe entenderse de la misma forma que la aromaticidad π, es decir como un ciclo donde la densidad electrónica se encuentra deslocalizada a través de enlaces σ. De igual forma, la aromaticidad δ puede ocurrir en anillos, principalmente de metales del bloque d, y ocurre por deslocalización electrónica a lo largo de enlaces de simetría δ de forma cíclica. Sin embargo, la deslocalización de los electrones de enlace puede darse de muchas formas. Contrario al criterio de la planaridad, existen moléculas aromáticas donde la deslocalización ocurre en tercera dimensión, como los fulerenos, los clusters de boro y de cierta forma el enlace metálico. La aromaticidad de Möbius es otro tipo de deslocalización electrónica que ocurre por la torsión de 180° de uno de los enlaces, lo que resulta en un traslape efectivo de orbitales, pero un plano nodal. El efecto total es la formación de un sistema deslocalizado con cierto grado de estabilización, es decir, con cierto carácter aromático.

Una de las diferencias principales entre los clusters metálicos y las moléculas orgánicas aromáticas es que éstos pueden presentar aromaticidad múltiple. La aromaticidad en anillos orgánicos puede explicarse de forma completa como un esqueleto sigma por el que circula un sistema π deslocalizado. Casi nunca se observa deslocalización electrónica a través de los enlaces σ para este tipo de moléculas. En contraste, en clusters metálicos se encuentra muy a menudo la aromaticidad σ, pero también la aromaticidad π en clusters de metales del bloque p. El problema es que en este tipo de anillos ambos tipos de deslocalización se pueden presentar al mismo tiempo, lo cual presenta un problema muy importante en el estudio de anillos inorgánicos: la aromaticidad neta. Los diferentes tipos de aromaticidad en una misma molécula son independientes, es decir, una molécula puede ser σ-aromática y π-anti-aromática al mismo tiempo, la combinación inversa también es posible, de igual forma es posible que sea aromática o anti-aromática en ambos tipos de deslocalización. Al haber orbitales d disponibles, puede haber deslocalización σ, π y δ en todas las combinaciones. Esto resulta complicado, ya que por un lado los componentes aromáticos contribuyen con una energía de estabilización, mientras que los componentes anti-aromáticos desestabilizan la molécula. El problema consiste en determinar cuál es el efecto que prevalece en el carácter general de la molécula.

Los anillos con deslocalización electrónica poseen una propiedad muy importante, la inducción de un campo magnético molecular. La deslocalización electrónica implica que los electrones están en movimiento continuo, lo que genera un campo magnético al que se le conoce como corriente anular. La resonancia magnética nuclear de hidrógeno se ocupa como criterio de aromaticidad en moléculas orgánicas ya que los compuestos aromáticos desprotegen los protones periféricos debido al reforzamiento del campo magnético externo con la corriente anular. En contraste, las moléculas anti-aromáticas protegen a los protones de la periferia y hacen que aparezcan a campo alto, a veces incluso más alto que el TMS. Este es un criterio satisfactorio siempre y cuando el anillo tenga hidrógenos.

Con la creciente importancia de la química cuántica y computacional como herramientas para entender la estructura molecular, han surgido nuevos criterios muy útiles que se basan en cálculos teóricos de estructuras, que permiten conocer cuál es la estructura más apropiada y cómo se distribuyen los orbitales moleculares del compuesto de interés. Un método actual interesante se basa en cálculos computacionales de la respuesta de una molécula a un campo magnético externo. Este criterio en particular es útil para entender la naturaleza magnética de las moléculas sin depender de un núcleo en particular, además ayuda a diferenciar entre las moléculas aromáticas y las anti-aromáticas. La limitación de esta técnica es que toma en consideración la respuesta al campo magnético de todos los componentes aromáticos, lo que implica que no es un buen criterio para diferenciar los diferentes tipos de aromaticidad y cómo influyen en el carácter neto de la molécula.

Uno de los criterios computacionales más importantes para el estudio de la aromaticidad es el llamado Nucleus-Independent Chemical Shifts (NICS), este método consiste en colocar un punto de prueba en cualquier parte del anillo, generalmente el centro, para calcular el valor absoluto de la protección magnética generada por la corriente anular. Los valores de NICS negativos indican que el anillo presenta aromaticidad, los valores positivos indican anti-aromaticidad, y los valores cercanos a cero indican no-aromaticidad. A pesar de la naturaleza teórica y el hecho de que se ocupa un núcleo imaginario, el método NICS se ha convertido en, quizás, el criterio más importante de aromaticidad; sin embargo, en moléculas policíclicas se tiene que calcular un valor de NICS para cada anillo que se sospeche aromático, así que NICS no puede arrojar información sobre la aromaticidad total de la molécula.

Existen otros índices de aromaticidad que se basan ya sea en funciones matemáticas o estadísticas. El índice llamado Harmonic Oscillator Model of Aromaticity (HOMA) es muy útil, ya que relaciona la estructura con la aromaticidad; además de que describe la contribución de la geometría y la energía de la molécula en la aromaticidad. Otros métodos consisten en consideraciones termodinámicas. Es bien sabido que la aromaticidad está relacionada con una energía de estabilización, mientras que la anti-aromaticidad contribuye a la desestabilización energética de la molécula; utilizando esta información, se puede calcular la contribución energética de los diferentes tipos de aromaticidad presentes en un anillo y de ahí calcular si prevalece la estabilización o desestabilización del anillo en conjunto.

La aromaticidad es un concepto muy interesante y una fuente de investigación muy amplia, tanto en química orgánica como en inorgánica, debido a las implicaciones que tiene sobre la estabilidad y la reactividad. Los clusters o anillos metálicos aromáticos deben entenderse desde el punto de vista de la deslocalización electrónica, justo como los anillos orgánicos, la única diferencia es que el estudio de anillos inorgánicos tiene dificultades adicionales. La aromaticidad múltiple introduce la necesidad de evaluar la aromaticidad neta del anillo para entender su comportamiento. Esto a su vez ha generado la necesidad de nuevos indicadores de aromaticidad que permitan cuantificar el grado de aromaticidad o anti-aromaticidad asociado. Además, como la deslocalización electrónica depende de un traslape efectivo de orbitales atómicos, hay distintas formas en las que esto puede ocurrir, como la formación de una tira de Möbius o la deslocalización esférica. La investigación sobre aromaticidad es amplia y con mucho futuro, sería importante salir del marco teórico y empezar a generar investigación experimental que permita entender mejor su reactividad, aunque muchas veces se tiene la limitante de los sustituyentes voluminosos que se ocupan para sintetizarlos. De cualquier modo, es un tema importante y probablemente pueda llevar a aplicaciones interesantes en un futuro.

Bibliografía

Metallabenzene Chemistry. John R. Bleeke. Acc. Chem. Res., 1991.

Gallanes, Gallenes, Cyclogallenes, and Gallynes: Organometallic Chemistry about the Gallium−Gallium Bond. Gregory H. Robinson. Acc. Chem. Res., 1999.

The Induced Magnetic Field in Cyclic Molecules. Gabriel Merino, Thomas Heine, and Gotthard Seifert. Chem. Eur. J. 2004.

Sigma- and Pi-Electron Delocalization: Focus on Substituent Effects. Tadeusz Marek Krygowski, and Beata Tamara Steüpien´. Chem. Rev., 2005.

Nucleus-Independent Chemical Shifts (NICS) as an Aromaticity Criterion. Zhongfang Chen, Chaitanya S. Wannere, Clmence Corminboeuf, Ralph Puchta, and Paul von Ragu Schleyer. Chem. Rev., 2005.

All-Metal Aromaticity and Antiaromaticity. Alexander I. Boldyrev, and Lai-Sheng Wang

Chem. Rev., 2005.

Möbius Aromaticity and Delocalization. Henry S. Rzepa. Chem. Rev., 2005.

Rationalization of the π-σ (Anti)aromaticity in All Metal Molecular Clusters. Ayan Datta, and Swapan K. Pati. J. Chem. Theory Comput., 2005.

Aromaticity of Distorted Benzene Rings: Exploring the Validity of Different Indicators of Aromaticity. Ferran Feixas, Eduard Matito, Jordi Poater, and Miquel Sol. J. Phys. Chem. A, 2007.

Nucleus-Independent Chemical Shifts: A Simple and Efficient Aromaticity Probe. Paul von Rague´ Schleyer, Christoph Maerker, Alk Dransfeld, Haijun Jiao, and Nicolaas J. R. van Eikema Hommes. J. Am. Chem. Soc. 1996.

María José Álvarez Miranda

Gerardo Martín Torres

Tuesday, May 12, 2009

Otra reacción a la lista

Nuevos catalizadores para obtener metano a partir de CO2

Sistema SEM-RAMAN

Morfología y número atómico promediode SEM (SEI y BEI)

Composición elementaldel análisis EDS

Composición química e identificaciónde espectrografía Raman

Estructura física(datos cristalográficos y mecánicos) de espectrografía Raman

Estructura electrónica y físicade espectroscopios CL y PL

Investigación de materiales

Industria farmacéutica

Investigación forense

Espectrografía simultánea SEM y Raman

EDS e imágenes de luz blanca a partir de la misma posición de la muestra

Espectroscopios de catodoluminescencia (CL) y fotoluminescencia (PL)

Transplante de cara

http://www.bbc.co.uk/mundo/ciencia_tecnologia/2009/05/090506_video_transplante_cara_vh.shtml

Aplicación Flash de RMN

http://www.spcollege.edu/SPG/Science/Musgrave/nmr.htm

http://arrhenius.rider.edu/nmr/nmr_tutor/selftests/c7/c7_fs_1.html

RESONANCIA MAGNÉTICA DE CUERPO ENTERO

B) ANGIORESONANCIA MAGNÉTICA DE CUERPO ENTERO(EN PACIENTES CON RIESGO VASCULAR) Con el suministro de un contraste no iodado ( gadolinio )que no produce alergia y gracias al movimiento automático del paciente en etapas sucesivas sin necesidad de reposicionamiento, se obtiene en tan sólo 2 minutos una imagen integrada de todas las grandes arterias del cuerpo (menos las del corazón), de gran utilidad en enfermedades sistémicas como la arterioesclerosis y la diabetes.

C) RASTREO ONCOLÓGICOPara determinar la extensión de los tumores habitualmente se utilizan varias modalidades de diagnóstico, tal como la medicina nuclear para buscar alteraciones óseas a lo que se agrega tomografía computada de cerebro, tórax y pelvis para la búsqueda de lesiones en los tejidos blandos. La RESONANCIA MAGNÉTICA DE CUERPO ENTERO es una opción que permite la búsqueda simultánea tanto en órganos blandos como en el hueso, con alta precisión diagnóstica y sin radiaciones. Hoy en día los pacientes oncológicos tienen más larga sobrevida y el cáncer se está transformando paulatinamente en una enfermedad crónica. Esta es la razón de porqué es tan importante determinar la extensión del tumor previo al tratamiento, lo que nos permitirá categorizar a los pacientes con mucha mayor precisión.

D) ENFERMEDADES REUMÁTICAS El método se utiliza para establecer con exactitud las diferentes articulaciones afectadas en algunas enfermedades reumáticas , siendo necesaria la inyección de gadolinio endovenoso.

E) RMCE PARA CUANTIFICACIÓN Y LOCALIZACIÓN DE LA GRASA CORPORALCon esta técnica es posible la cuantificación del contenido graso corporal y su distribución, destacándose en particular la medición de la grasa como un porcentaje de la masa corporal total. Esto se utiliza para monitorear la obesidad cuando ésta está ligada a condiciones clínicas importantes como la hipertensión enfermedad vascular coronaria y la diabetes.

Para Reflexionar

La Biblia leída con microscopio

Este artículo me hizo recordar a Feynmann,diciendo que algún día sería posible escribir toda la enciclopedia británica en la punta de un alfiler.

Los avances en la nanotecnologia lo dejan a uno cada vez más perplejo. En este caso se vincula ciencia, tecnología y religión —colegas enemigas que han batido algunas de las guerras más importantes de la historia— para lograr un resultado más pequeño que la cabeza de un alfiler.

Se trata de la Biblia Hebrea más diminuta del mundo, la cual tiene un tamaño tan pero tan pequeño que es parecida a un grano de azúcar.

Utilizando rayos de partículas minúsculas denominados iones de galio, científicos y nanotecnólogos del Instituto de Tecnología de Haifa (Technion) han logrado escribir las 300.000 palabras que constituyen la Biblia Hebrea en una superficie de tan sólo 0.5 milímetros.

Por supuesto que los científicos implicados en esta hazañosa empresa procuran ingresar al Libro Guinness de los Récords, el cual ha registrado una Biblia cincuenta veces más grande que la Biblia en cuestión.

Los expertos planean tomar fotos de esta curiosa edición de la Biblia, para luego exhibirlas en un afiche de 7 x 7 metros en la Facultad de Física. Al costado de esta exhibición se mostrará el ejemplar original de la nanobiblia, haciendo un contraste entre el tamaño original y el tamaño ampliado. Eso sí, para encontrar la Biblia original se deberá usar una lupa, o incluso un microscopio.

http://news.bbc.co.uk/hi/spanish/science/newsid_7159000/7159957.stm

IBM desarrolla un microscopio para observar virus en 3D

Las Imágenes de Resonancia Magnética (M.R.I.) es una técnica que todos conocemos, o al menos hemos sentido nombrar. Se trata de la técnica más avanzada para observar las moléculas y su comportamiento, y actualmente es la que utilizan las ciencias naturales para explorar nuestro organismo entre otros objetos de estudio. Pero IBM ha ido un paso más allá de ella, creando un microscopio que supera notablemente el alcance de la M.R.I.

M.R.F.M. (Magnetic Resonance Force Microscopy) es la técnica que utiliza este nuevo microscopio desarrollado por IBM, el cual fue diseñado en el Centro de Investigaciones Almaden en San José, California, y que ha sido presentado en The Proceedings of the National Academy of Sciences.

La M.R.F.M es una técnica que permite observar virus en tres dimensiones con herramientas de la nanotecnología y la ayuda de un campo magnético. La técnica permite ampliar en cien millones de veces el alcance de la M.R.I. tradicional, y con ella se planean conseguir éxitos sin precedentes en biología y en medicina. A continuación se explica en qué consiste la misma.

Básicamente se utiliza una plataforma con especímenes de virus sobre ella, los cuales se mueven aumentando y disminuyendo la intensidad de un campo magnético que ejerce una influencia en sus átomos de hidrógeno. Al efectuar tales cambios, los virus vibran sobre la plataforma, y moviéndolos con el campo magnético se pueden captar muchas imágenes 2D a partir de las cuales construir una imagen 3D de los ejemplares.

Las repercusiones de una técnica como esta son importantísimas para el estudio de las proteínas en general y de sus interrelaciones. Siendo claros, ampliando el conocimiento de los virus se podría aproximarse con mayor firmeza al comportamiento de virus variables y mutables, tales como la gripe o hasta el SIDA. Dejamos un video explicativo que muestra cómo funciona el procedimiento

http://www.ojocientifico.com/2009/01/13/ibm-desarrolla-un-microscopio-para-observar-virus-en-3d/

Microscopio Microscópico

"El objeto es verdaderamente compacto" afirma el profesor Changhuei Yang, quien desarrolló el aparato que ha sido llamado microscopio optofluidico. "Puede colocarse en teléfono móvil y utilizar solamente rayos solares para su iluminación", agrega.

Según los expertos, el aparato podría revolucionar la forma como se diagnostican ciertas enfermedades como la malaria, por lo que podría ser una herramienta muy útil para el mundo en desarrollo. Por ejemplo, explican los investigadores, el microscopio puede ser utilizado en regiones remotas que no cuentan con equipos de diagnóstico y con una muestra de sangre puede detectar malaria. O también serviría para analizar si hay patógenos que propagan enfermedades en los abastecimientos de agua.

Así, el chip del microscopio optofluidico mide solamente 1,5 centímetros. "Los microscopios han existido desde el siglo 16 -dice el profesor Yang- y sin embargo su diseño básico ha sido objeto de muy pocos cambios". Además, agrega el investigador, hasta ahora ha sido increíblemente caro poder miniaturizar estos aparatos.

Por esta razón los investigadores basaron su diseño en un principio diferente con el cual no es necesario utilizar lentes ni otros elementos ópticos voluminosos.

El chip es iluminado desde la parte superior y, según los investigadores, la iluminación de la luz solar es suficiente. Cuando se coloca la muestra, ésta fluye hacia la línea de orificios en el metal. Y a medida que los pequeños organismos o las células se introducen en los orificios, el sensor produce una serie de imágenes, que después pueden ser analizadas.

Producción en masa

Los investigadores están ahora en conversación con varias compañías de biotecnología para producir el chip en masa. Se espera que este pueda utilizarse en varios tipos de plataformas dependiendo de las necesidades del usuario, desde comunidades rurales hasta campos de batalla.

Y en el futuro, dicen los científicos, estos microscopios optofluidicos se incorporarían en aparatos que podrían ser implantados en el cuerpo humano.

"Un sistema de análisis de microscopio implantable podría de forma autónoma analizar y aislar células cancerígenas en la circulación sanguínea", dice el profesor Yang.

"Y esto podría ofrecer una importante información de diagnóstico y quizás ayudar a detener la propagación de cáncer".

http://news.bbc.co.uk/hi/spanish/science/newsid_7529000/7529638.stm

Espectrofotómetro en Bares

Así que si alguién se anima a trabajar en el gobierno, hay grandes posibilidades de hacerlo en la secretaria de salud.

Telescopio Espacial de Rayos Gamma

¿Qué es lo que pretende lograr la NASA con la puesta en órbita de este nuevo telescopio? GLAST explorará los ambientes más extremos del universo, buscando cualquier tipo de señal que sugiera nuevas leyes de física, investigando la naturaleza de la materia oscura, así como también muchas otras cosas.

Una violenta historia del tiempo

Desde nuestra madre Tierra, el cielo nocturno puede parecer tranquilo e inmutable, pero el universo visto en rayos gamma es un lugar de violencia repentina y caótica. Utilizando telescopios sensibles a los rayos gamma, los astrónomos son testigo de explosiones breves pero tremendamente intensas, llamadas explosiones de rayos gamma. No existe nada más potente.

Nadie está seguro de qué es lo que causa las explosiones de rayos gamma. Entre las posibilidades predilectas están la colisión de dos estrellas de neutrones o un tipo de super supernova que se produce cuando explota una estrella extremadamente masiva. Una cosa es cierta: las explosiones de rayos gamma tienen lugar en galaxias muy pero muy lejanas, tan lejanas que a sus distancias se las llama "cosmológicas", y se encuentran más allá de la comprensión normal.

Derecha: Concepción artística: Una explosión de rayos gamma destruye una estrella. Crédito: NASA/SkyWorks Digital.

Las explosiones de rayos gamma no solamente ayudan a los científicos a entender la historia del universo, sino que también colaboran para explicar la física oculta que hay detrás de ellas. Pero la parte difícil del estudio de las explosiones de rayos gamma es encontrarlas antes de que desaparezcan. Cada explosión ocurre y desaparece tan rápido que es difícil detectar todas las que se producen. Es como tratar de capturar cada uno de los destellos de las luciérnagas con una cámara común y corriente en una noche de verano.

El Telescopio Espacial de Rayos Gamma de Gran Área (GLAST, por su sigla en idioma inglés), de la NASA, pronto ayudará en la búsqueda. Informaremos más sobre este tema en un minuto pero, primero, vamos a crear el escenario propicio con un poco de historia.

Los científicos han estado tras la pista de los rayos gamma durante muchos años, pero las explosiones de estos rayos fueron descubiertas por accidente. Durante la Guerra Fría, que tuvo lugar en la década de 1960, los satélites de Estados Unidos que vigilaban las pruebas nucleares soviéticas, y violaban de ese modo el Tratado de Prohibición Limitada de Pruebas, detectaron intensos destellos de radiación gamma. Sin embargo, los destellos no provenían de la Unión Soviética. ¡Los científicos se dieron cuenta de que los destellos venían del espacio!

Rápidamente, las explosiones de rayos gamma se convirtieron en uno de los misterios más cautivadores de la astronomía y la NASA decidió construir un Gran Observatorio para trazar un mapa de los rayos gamma que provienen del cielo. En la década de 1990, el Observatorio Compton de Rayos Gamma descubrió más de 400 nuevas fuentes de este tipo de rayos y registró 2.704 explosiones, detallando así el universo de rayos gamma que los primeros satélites apenas habían alcanzado a ver. Pero lo que es más importante es que Compton dio a conocer evidencia de que las explosiones de rayos gamma no se generan en la Vía Láctea, sino en galaxias ubicadas a enormes distancias.

Asimismo, los astrónomos se dieron cuenta de que, para que puedan verse a tan grandes distancias, las explosiones debieron de haber sido violentas a un grado casi imposible. De cierta manera, esto no fue una sorpresa. Los rayos gamma son, por su naturaleza misma, una muestra de gran energía y violencia. Tome en cuenta lo siguiente: los rayos gamma son una forma de luz super energética. Los fotones de luz común, como los que vemos con nuestros propios ojos, tienen energías del orden de 2 a 3 electronvoltios. Los rayos gamma tienen energías superiores a los 10 gigaelectronvoltios (GeV), lo que es miles de millones de veces mayor que la energía de la luz visible. Observatorios en la Tierra han detectado rayos gamma con energías aún mayores —de miles de GeV.

La NASA ha lanzado el GLAST para dar la bienvenida a estos mensajeros de alta energía. El instrumento principal del GLAST, el Telescopio de Gran Área (LAT, por su sigla en idioma inglés), efectuará observaciones pioneras de las explosiones de rayos gamma a energías superiores a cualquier otra que se haya detectado previamente. Se espera que pueda ubicar de manera precisa alrededor de 50 explosiones por año. Mientras tanto, otro instrumento a bordo del GLAST, el Monitor de Explosiones del GLAST (GBM, por su sigla en idioma inglés), registrará las explosiones de rayos gamma a energías más bajas.

Trabajando juntos, estos dos instrumentos detectarán el rango completo de energías de estas luciérnagas cósmicas (desde 10 mil electronvoltios hasta 100 Gigaelectronvoltios).

"Capturar los eventos en más de una longitud de onda ayudará a los científicos a entenderlos mejor, esto es semejante a poder ver en colores en lugar de hacerlo en blanco y negro", dice Meegan. "No podemos reproducir en ningún laboratorio las condiciones físicas extremas en las que tienen lugar las explosiones de rayos gamma, por lo que no entendemos cómo funcionan. Estudiándolas con estos instrumentos, es posible que podamos conocer una nueva física de la materia".

"Creo que es muy probable que el LAT y el GBM vean algo nuevo e imprevisto de las explosiones de rayos gamma. Posiblemente, responderán algunas viejas preguntas y surgirán otras nuevas". "

Químicos descubren rara molécula de Rydberg con un nuevo tipo de enlace

James Shaffer, profesor de la Universidad de Oklahoma en el departamento de Física, fue parte del grupo que realizó el descubrimiento, el cual, según diversas afirmaciones, demuestra un “nuevo” tipo de enlace, el cual hace de esta molécula de Rydberg distinta a las ya conocidas. La dispersión de los electrones según este enfoque puede ser usada para llevar a cabo futuros cálculos cuánticos de estructuras atómicas y moleculares.

Shaffer explica que un enlace débil se forma cuando un electrón lejano al núcleo y otro átomo de estado fundamental interactúan. El electrón es ligeramente atraído hacia el átomo de estado fundamental y viceversa. El electron jala al átomo de estado fundamental hacia el átomo de Rydberg lo suficiente para que no escape. El resultado es una rara molécula de Rydberg como la producida por el equipo de investigación.

La formación de la molécula no pudo haber ocurrido de no ser por las bajas temperaturas logradas usando enfriamiento con láser combinado con la densidad de las más avanzadas trampas de átomos.

Los investigadores de la Universidad de Oklahoma se encuentran buscando los mismos tipos de moléculas formadas por átomos de cesio, sin embargo, un átomo de cesio es ligeramente diferente debido a que existen más de un tipo de molécula dependiendo de la alineación de los spins del sistema. Esta característica puede ser usada para entender cómo interactúan los momentos magnéticos del electrón y del átomo.

Monday, May 11, 2009

Tanto, para quedarnos sin trabajo

"Adam", un mini laboratorio autónomo que usa computadoras, robótica y equipo de laboratorio para llevar a cabo experimentos científicos, automaticamente genera una hipótesis para explicar los resultados de los datos obtenidos, a su vez examina estas hipótesis , y por último interpreta los resultados.

Invesitagadores de la Universidad Aberystwyth en Gales y la universidad de Cambridge en Inglaterra reportaron en Science today que diseñaron a Adam que mide 5 metros de longitud y 3 metros de altura, para realizar experimetnos básicos biológicos con la mínima intervención humana. Ellos describen como opera el robot, relacionando comoo llevó a cabo una de sus tareas, en el caso de los investigadores averiguar más sobre el maquillaje genético de Saccharomyces cerevisiae, un organismo usado para crear modelos complejos de sistemas de vida.

Fuente: http://www.scientificamerican.com/article.cfm?id=robots-adam-and-eve-ai

2011: Año Internacional de la Química

1. El entendimiento y por lo tanto la capacidad para transformar y utilizar la materia que constituye nuestro mundo se basa en la ciencia química.

2. La educación química es esencial para solucionar los enormes retos que actualmente enfrenta la humanidad para su sobrevivencia, como son el cambio climático, la producción suficiente de agua limpia, de alimentos y de energía, así como la conservación del medio ambiente.

3. El desarrollo y aplicación de la química hace posible la producción de medicinas, combustibles y prácticamente todos los productos necesarios en nuestra vida diaria.

4. El año 2011 ofrece la oportunidad de celebrar las contribuciones de las mujeres a la ciencia en ocasión del primer centenario del otorgamiento del Premio Nobel de Química a María Sklodowska-Curie.

5. La designación del año 2011 como “Año Internacional de la Química” da la oportunidad de establecer un mayor número de colaboraciones científicas entre las diversas naciones.

Ahora, la IUPAC pone a nuestra disposición el siguiente sitio: http://www.iupac.org/web/nt/2008-12-30_IYC para anunciar todos los festejos y actividades que se realicen a nivel mundial.

Hule de metal

Fuente: http://www.sciencedaily.com/videos/2007/0409-metal_rubber.htm

Deuterio ultra-denso

La mejor aplicación a estudiar de este material es como combustible en la fusión nuclear inducida por láser ya que se podría obtener la fusión nuclear entre los núcleos de deuterio a través de láseres de alta potencia, haciendo posible la producción de grandes cantidades de energía. Este descubrimiento abriga esperanzas puesto que, al contrario del deuterio congelado, este material presenta distancias intramoleculares “anormalmente” cortas y es un millón de veces más denso aproximadamente.

El mérito de la síntesis fue para el equipo de investigación del departamento de

química en la Universidad de Gothenburg.

University of Gothenburg (2009, May 12). Ultra-dense Deuterium May Be Nuclear Fuel Of The Future. ScienceDaily. Retrieved May 11, 2009

http://www.sciencedaily.com/releases/2009/05/090511181356.htm

Attoreactores químicos para zeptomoles de reactivos en volúmenes de attolitros

El agua: catalizador en reacciones explosivas

Saturday, May 09, 2009

Plomo y voltametría de redisolución anódica

El plomo es un metal pesado que no juega ningún papel en la

Los instrumentos portátiles pueden ofrecer resultados analíticos expeditos para los profesionales de la salud, y en áreas donde se carece de la infraestructura analítica o de laboratorio. Se utiliza para analizar rápidamente niveles del plomo de la sangre venosa en los individuos, y emplea la voltametría de redisolución anódica (ASV) para medir el plomo en la sangre. Es un instrumento desarrollado por los centros para el control de enfermedad y la prevención (CDC, por sus siglas en inglés), diseñado para proporcionar una determinación rápida y rentable para monitorear las exposiciones al plomo.

El instrumento (ASV) comercialmente llamado LeadCare es un instrumento portátil de campo, que sirve para monitorear el plomo en la sangre para profesionales de la salud. En vez de esperar días o semanas, que se esperan para obtener los resultados por medio de absorción atómica, los empleados con niveles de plomo en sangre serán identificados rápidamente en minutos a horas.

Una de las técnicas que se utilizan para el análisis cuantitativo de metales traza es la voltametría de redisolución anódica, sin embargo esta técnica electroanalítica también se puede utilizar con fines cualitativos, debido a que en el rango de potencial establecido en el análisis, se puede obtener una visión analítica simultánea del contenido de iones metálicos presentes. La voltametría de redisolución anódica consta de tres etapas básicas: La primera es la preconcentración , aquí los iones de interés presentes en la solución, se reducen y el metal formado se deposita en la superficie de una microgota suspendida de mercurio. La segunda etapa es la de redisolución, aquí los elementos metálicos depositados en la superficie de la gota, se oxidan pasando nuevamente a la disolución y en la ventana de potencial del barrido anódico, aparece señales voltamétricas que son características para cada metal y corresponden al potencial de media onda (E ½) de cada uno de ellos, finalmente en la tercera etapa se registran las curvas de corriente potencial, tanto para los estándares como la muestra problema. De acuerdo al potencial en que aparece cada señal voltamétrica, se puede inferir la presencia o ausencia de cada metal en la muestra.

William Hallowes Miller

Sincrotón

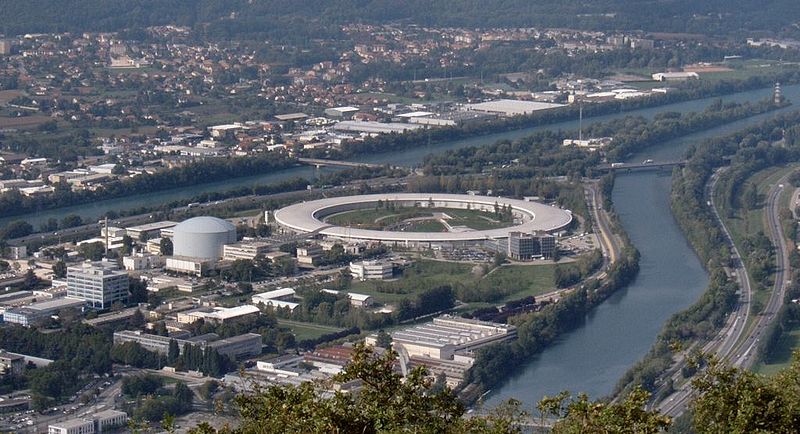

A diferencia de un ciclotrón que usa un campo magnético constante (que hace que las partículas giren) y un campo eléctrico constante (para acelerar las partículas), y de un sincrociclotrón, el cual varía uno de los dos campos, en el sincrotrón ambos campos se hacen variar para mantener el camino de las partículas de forma constante, o sea, el radio no varía demasiado. En el ciclotrón isócrono, se construye un imán tal que el campo magnético es más fuerte cuando está más próximo a la circunferencia que en el centro de la misma, de esta manera se genera un aumento total y se mantiene la revolución a una frecuencia constante. En este dispositivo, un anillo de imanes rodea un tanque en forma de anillo de vacío. El campo magnético se incrementa con las velocidades del protón, las partículas se deben inyectar en un sincrotrón de otro acelerador.

El primer sincrotrón de protón fue el cosmotrón usado en el Laboratorio nacional Brookhaven (Nueva York), y comenzó a operar en 1952, logrando una energía de 3 GeV. Otro que le siguió fue el sincrotrón 500-GeV del laboratorio estadounidense Fermi National Accelerator en Batavia, Illinois, construido para ser el acelerador de más alcance del mundo a inicios de los años 70; su anillo delinea una circunferencia de aproximadamente 6 kilómetros. Esta máquina fue actualizada en 1983 para acelerar protones y contar antiprotones que se propagan a velocidades tan enormes que los impactos que sobrevienen entregan energías de hasta 2 billones (tera-) de electronvoltios (TeV), por ello el anillo se ha duplicado en el Tevatron.

El Tevatrón es un ejemplo de una máquina que sería capaz de producir choques de rayos, y que es realmente un acelerador doble que se sobrealimenta de la separación de 2 rayos, luego de que estos chocan de frente o en un determinado ángulo de incidencia. Según efectos relativistas, producir las mismas reacciones con un acelerador convencional requeriría un solo rayo que al golpear un blanco inmóvil produciría mucho más de dos veces la energía liberada por cualquiera de los rayos que chocan.

Aceleradores de mayor alcance de velocidad son construidos ampliando el radio y usando compartimientos más numerosos y con gran alcance de microondas para acelerar la radiación de la partícula en los puntos tangenciales. Las partículas más ligeras (tales como electrones) pierden una fracción más grande de su energía al dar vuelta, ya que se mueven mucho más rápidamente que un protón de la misma energía, así que los sincrotrones de la alta energía aceleran partículas más grandes; protones o núcleos atómicos. Por ello se dice que el sincrotrón se puede utilizar para acelerar electrones pero es ineficaz. Una máquina circular que acelera electrones es el betatrón, inventado por Donald Kerst en 1939. Los electrones se inyectan en un compartimiento en forma de anillo de vacío que debe estar rodeado de un campo magnético. El campo magnético se aumenta constantemente, de tal forma que induce un campo eléctrico tangencial que acelerará a los electrones.

Sincrotrones actuales

Al parecer el elevado costO es el factor limitador en fabricar aceleradores de partículas pesadas. El CERN, en Europa está desarrollando actualmente aceleradores un poco menos ambiciosos que avanzarán perceptiblemente en la forma de manejo de energía. Mientras hay potencial para todo tipo de aceleradores cíclicos de partículas pesadas, parece ser que la siguiente etapa demanda intensificar la energía de aceleración del electrón por la necesidad de evitar las pérdidas debido a la radiación sincrotrón. Esto motivará una vuelta al acelerador lineal, pero cuyos dispositivos serán notoriamente más largos que los actualmente en uso. Sin embargo la radiación sincrotrón es usada por muchos científicos y para ellos la producción de la radiación sincrotrón es el único propósito del mismo. La radiación sincrotrón es útil para una amplia gama de usos y muchos sincrotrones se han construido especialmente para producir su luz. SPring-8 en Japón es uno de ellos: su capacidad de alcance es la mayor en el mundo en lo que se refiere a aceleración del electrón (en fecha 2005) y es de 8 GeV.

¿No que no?

Hasta ahora la molécula sólo existía teóricamente, pero el equipo de investigación alemán logró formar este tipo de interacción entre un átomo de rubidio y otro átomo Rydberg del mismo elemento. Rb(5s) – Rb(ns) donde n (número cuántico principal) toma valores ente 34 y 40. La manera en que se caracterizó este dímero fue a través de espectroscopía, permitiendo obtener el espectro vibracional del estado basal y el primer estado excitado de la molécula, concordando con los resultados computacionales obtendidos con anterioridad.

La síntesis de este dímero significa el refuerzo de las teorías de Enrico Fermi (Premio Nobel) que predecían la forma en que dos átomos interactuaban cuando un electrón se encontraba lejos del núcleo.

http://www.sciencedaily.com/releases/2009/05/090507130439.htm

http://www.nature.com/nature/journal/v458/n7241/full/nature07945.html

http://www.bbc.co.uk/mundo/ciencia_tecnologia/2009/04/090423_molecula_men.shtml

Microscopio de efecto túnel

Esta intensidad se denomina intensidad de túnel y es el parámetro de control que nos permite realizar la topografía de superficie.

Este efecto cuántico aparece también en otras ramas de la física. Gamow lo aplicó para dar explicación a la desintegración mediante emisión de partículas alfa en núcleos inestables. En electrónica, hay transistores que basan parte de su funcionamiento en el efecto túnel.

La instalación consiste en un circuito eléctrico en el que están incluidos la muestra y la punta de medida. Como se ha apuntado anteriormente, el parámetro de medida es la intensidad de corriente túnel. Esta intensidad apenas alcanza los nanoamperios y, además, es muy sensible tanto a la distancia, como a la diferencia de tensión entre la punta y la muestra. Debido a esta sensibilidad todo el sistema debe estar controlado electrónicamente. Así, la toma de medidas y los movimientos de la punta (realizados mediante un dispositivo piezoeléctrico con precisiones que pueden llegar a los 0.05 nm) son controlados por el usuario, a través de las interfases correspondientes, por ejemplo: mediante un PC de sobremesa.

La punta no toca la muestra, sino que se queda a una distancia equivalente a un par de átomos (del orden de angstroms) de la superficie. El PC registra la trayectoria de la punta y entonces se puede desplegar la información como una imagen en escala de grises a manera de mapa de densidades o mapa topográfico. A la imagen se le puede agregar color sólo para mejorar el contraste y así observar mejor los cambios detectados.

Caracterización de dominios magnéticos a nivel atómico

Nanolitografía

En la imagen se observa un "corral" cuántico creado mediante el desplazamiento de átomos de hierro sobre una superficie de cobalto.

Desde 1989 Donald Eigler y Erhard Schweizer del Centro de investigación Almaden de IBM comenzaron a utilizar el STM para manipular átomos individuales, logrando "escribir" las siglas de la compañía con 35 átomos de xenón sobre una superficie de níquel.

http://www.madrimasd.org/cienciaysociedad/ateneo/temascandentes/nanotecnologia/default.asp

Contaminación radioactiva

- Un litro de agua normal posee unos 340 pCi de radioactividad natural debidos en su mayor parte al 40K (en más de un 90%) y al 87Rb.

- En el medio marino, los organismos están sometidos a dosis de 1-3 mrad/año y los cercanos a la superficie, por efecto de la radiación cósmica, dosis de 25-35 mrad/año.

- En fondos graníticos se dan dosis de 90 mrad/año y en algunos fangos hasta 600 mrad/año.

- El plancton posee hasta un 80% de radioactividad artificial, proveniente de la acción del hombre: explosiones nucleares y desechos de centrales nucleares (135Xe, 85Kr, 90Sr, 131I, 137Cs, 144Ce, 106Ru, 89Sr, 140La, 129Te, 143Pr, 140Ba, 95Zr, 65Zn, 58CO, 55Fe, 59Fe, 54Mn, 124Sb, 110Ag y 51Cr). Por ejemplo: por ejemplo la central francesa de Chooz vierte un 30% de 134Cs, un 30% de 137Cs y un 22% de 131I

Explosiones nucleares:

La mayor parte de la radioactividad artificial en el mar es debida principalmente a la contaminación producida por explosiones nucleares en la atmósfera. Así RAVERA (1978) muestra una correlación entre la radiación beta atmosférica (Figura 1) y la concentración en 90Sr en el molusco Tellina pusilla del Adriático.

Los valores mayores de esta polución radioactiva en el mar y de los seres vivos que en él habitan se produjo entre los años 1962 y 1963, cuando varios países experimentaron explosiones nucleares. A partir del Tratado de Moscú (1963) sobre limitación de estos experimentos, se observó una progresiva disminución y un retorno a niveles más bajos de isótopos radioactivos en los animales marinos.

- Algunos elementos como el 137CS y el 90Sr resultan particularmente peligrosos para el organismo dado que se comportan en forma similar al K y Ca, elementos indispensables en el ser vivo. La regulación bioquímica del Cs (y por tanto del isótopo 137CS) es llevada a cabo por los mecanismos de regulación del potasio. Este cesio se acumula preferentemente en los músculos (53%) y en la piel (31%) de los peces. El cesio se acumula poco en las algas feoficeas, pero si empobrecemos artificial mente estas aguas en K, el factor de concentración de Cs se eleva rápidamente. Así pues existe un mecanismo de corregulación de estos elementos.

- Otra categoría de elementos radioactivos son aquellos que en estado normal forman parte activa en el metabolismo de los seres vivos; sodio, potasio, calcio, magnesio, cobalto, hierro, etc...

- El tercer grupo incluye una gran cantidad de elementos de elevado número atómico (lantánidos y transuránidos) que no poseen ningún papel en el mecanismo bioquímico de los seres vivos. Respecto a las vías de entrada en el organismo de estos radioisótopos, pueden ser: mediante el agua, por los alimentos y por el sedimento.

Efectos de radioactividad

- Somáticos: las dosis son altas y producen daños en el organismo

- Genéticos: las dosis son suficientemente bajas para no evidenciar efectos nocivos en el organismo pero afectan a las células reproductoras produciendo variaciones genéticas irreversibles en la descendencia, es difícil de prevenir.

- Transferencia al hombre de radioisótopos presentes en animales marinos.

- Descenso de las poblaciones de especies comerciales por efecto directo de la radiación.

- Reducción de estas poblaciones debido a alteraciones o desequilibrios ecológicos producidos por las radiaciones.

Bacterias reciclando radioactividad

Algunas bacterias marinas son capaces de acumular elementos radio- activos como el 90Y con factores de concentración superiores a 20.000, asimismo las algas son de gran ayuda para contrarrestar niveles de 141Ce de 8.000 y para el 65Zn de 164

Las bacterias pueden transferir radioisótopos a organismos superiores a través de la cadena trófica, así el crustáceo Gammarus locusta acumula 32P, pero al añadir antibiótico (terramicina) al medio, esta acumulación cesa, lo cual demuestra cómo Gammarus obtiene su alimento (y con él el 32P) de las bacterias.

Este mecanismo de acumulación observado experimentalmente en laboratorio tiene particular interés en los organismos filtradores que se alimentan de bacterias, así también el molusco lamelibranquio Tapes decussatus para la acumulación del 54Mn.

Las bacterias autótrofas o quimiótrofas son capaces de transformar la materia mineral en orgánica y por lo tanto pueden incorporar elementos radioactivos transfiriéndolos a la cadena trófica. Otro ejemplo típico es la acumulación de cobalto que forma parte de la vitamina 812 sintetizada por las bacterias, que en un medio polucionado por contaminación radioactiva puede ser 60CO.

Dato curioso: las cucarachas son capaces de soportar dosis de radiactividad de 6 a 15 veces superiores a las de los seres humanos, aunque no son insectos tan resistentes a la radiación como Drosophila, la mosca de la fruta, o la avispa parasitoide Habrobracon.

Bibliografía

http://e-nimals.com/curiosidades/datos-curiosos-de-las-cucarachas/

http://www.ingeba.euskalnet.net/lurralde/lurranet/lur03/smi03/03smil.htm

NEODIMIO ¡no te lo pierdas!

-

De entre todos los compuestos químicos que existen, quizá sean los llamados compuestos de coordinación los que mayores dificultades ofrecen ...

-

Básicamente el video habla por sí sólo. Se tiene una cerveza fría líquida recién sacada del refrigerador o congelador, se le da un golpe y e...